Samsung ohlásil SOCAMM2, počítá se už prakticky jen s AI servery

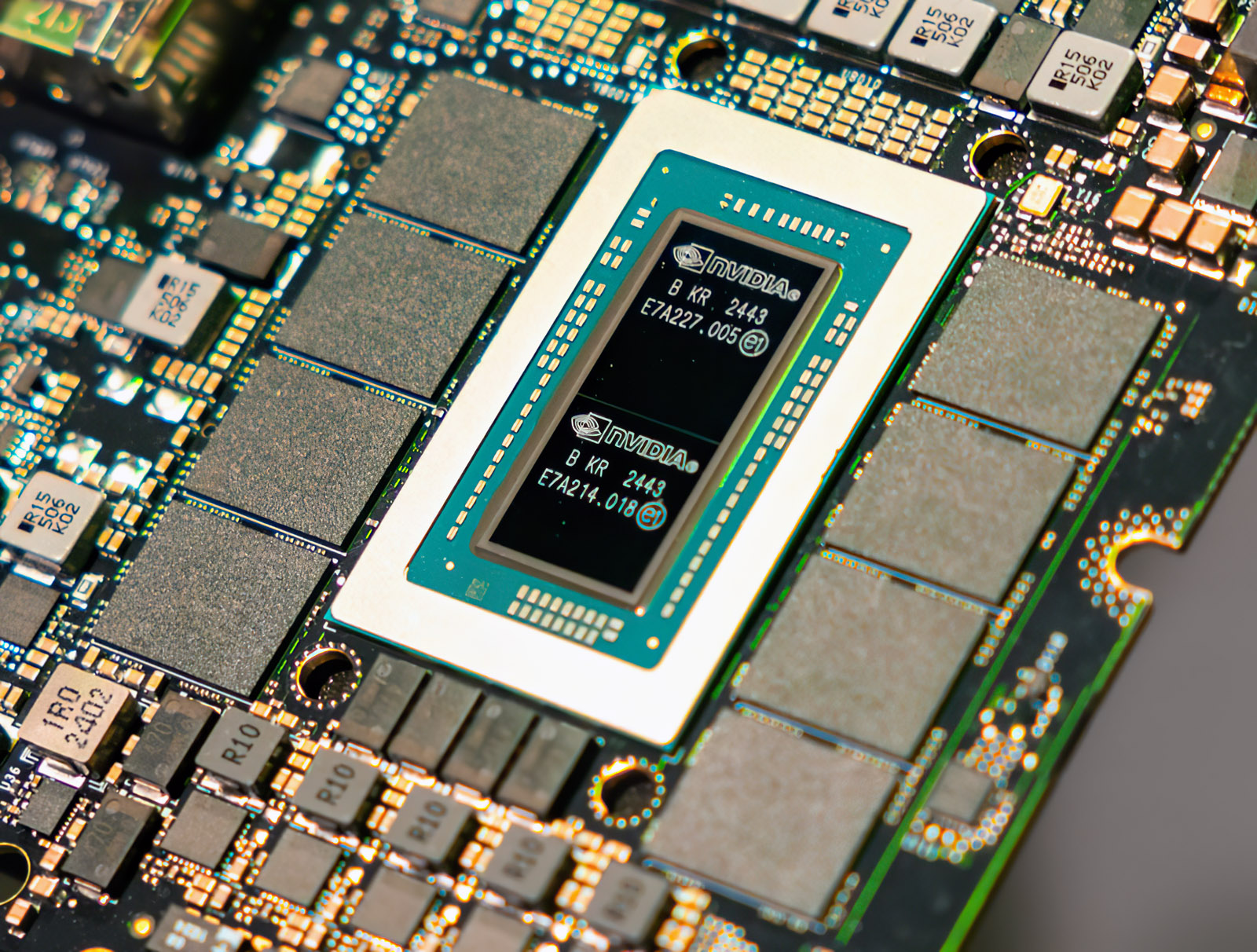

Když se v březnu letošního roku začalo mluvit o paměťových modulech SOCAMM, které navrhla Nvidia a na jejich realizaci se podílel Micron a částečně též Samsung a Hynix, bývaly zmiňovány nejen AI servery, ale také SoC GB10, který již Nvidia vydala ve stolním provedení a který měl (a stále se to očekává) dorazit i v mobilním provedení, v podobě notebooků. SOCAMM moduly byly prezentovány jako řešení, které je ještě úspornější (plošně i energeticky) než LPCAMM, a tak to vypadalo, že se po premiéře v AI segmentu objeví i v mobilní sféře, kam se dostanou s GB10.

Od března se ale změnilo mnoho. Nvidia první generaci SOCAMM vzdala, protože nebyla s výsledky spokojená, GB10 nabral zpoždění (v mobilním segmentu dosud absentuje), ceny pamětí vyletěly nahoru a trend posunu profesionálních řešení ke konzumním je prakticky nulový. Naopak je tu trend posunu konzumních řešení (LPDDR5X, GDDR7) do profesionálního segmentu.

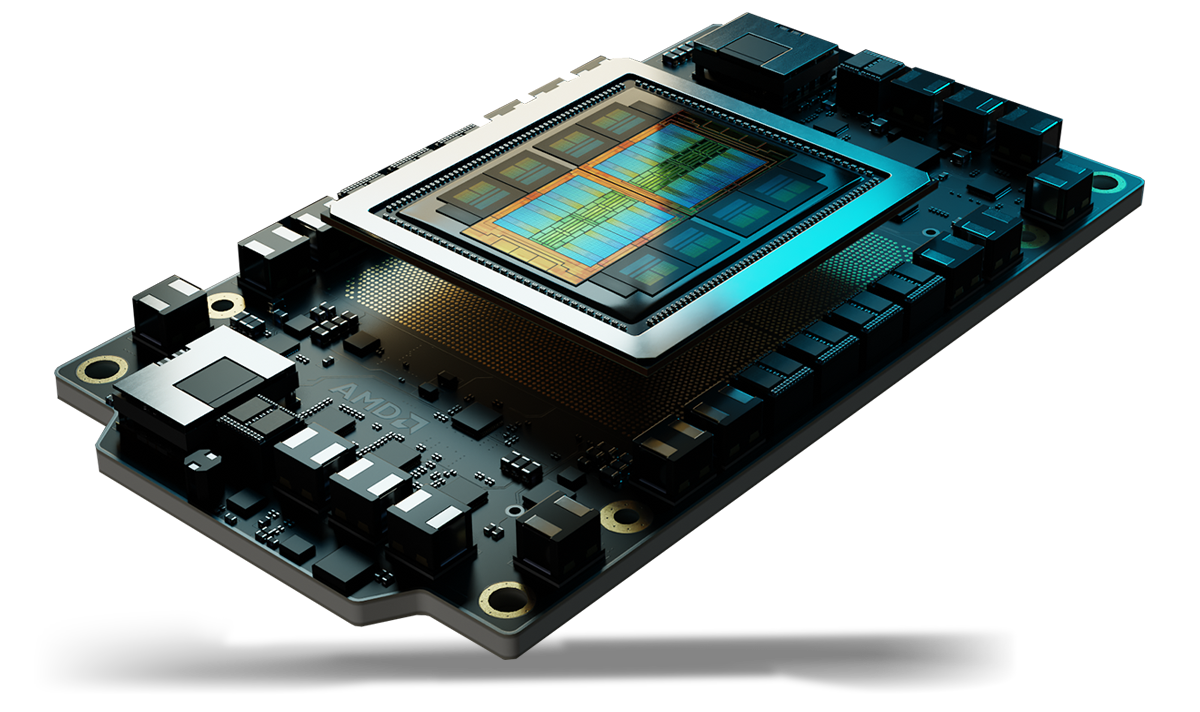

V podstatě tak není divu, že výrobci pamětí, kteří v poslední době hovoří o SOCAMM2, druhé generaci těchto modulů, už mluví výlučně o serverech. Nejinak je tomu u Samsungu, který aktuálně představil vlastní SOCAMM2, které mají (oproti RDIMM) snížit energetické nároky o 55 %. Samsung žádné další technologické srovnání nenabízí, takže si ho doplníme sami.

SOCAMM oproti LPCAMM (které byly vyvinuté primárně pro mobilní segment a dost možná Nvidii inspirovaly) mají mírně širší rozhraní: 694 pinů oproti 644 (a 260 u SODIMM či 288 u RDIMM DDR5). SOCAMM2 oproti SOCAMM se v hlavních parametrech liší spíše evolučně. Díky použití novější technologie na výrobu osazených čipů s počítá až s cca LPDDR5X-9600 namísto LPDDR5X-8533, nechává se otevřená možnost pozdějšího osazení LPDDR6, maximální kapacita (opět díky pokročilejším čipům) stoupla ze 128 na 192 GB pro modul a energetická efektivita měla vzrůst až o 20 %.

Závěrem nebude od věci ještě jedno upřesnění. Přestože byly médii SOCAMM prezentované jako jakási levnější náhrada HBM pro AI akcelerátory, ve skutečnosti je situace jiná a prozatím nic nenaznačuje takové využití. Vlastně to ani není možné. Pro příští rok se u Nvidie počítá s akcelerátory Rubin, které s HBM4 dosáhnou více než 20 TB/s na GPU. Se čtyřmi moduly SOCAMM při LPDDR5X-9600 lze dosáhnout přinejlepším 0,6 TB/s, tedy datové propustnosti prakticky o dva řády nižší. Levnější alternativou HBM budou rychlé GDDR7. SOCAMM a LPDDR5X sice mají místo v AI, ale - jak ukazuje i grafika Samsungu - mají své místo kolem CPU, kde (oproti současné generaci) v podstatě jen nahrazují LPDDR5X napájené přímo na desku.