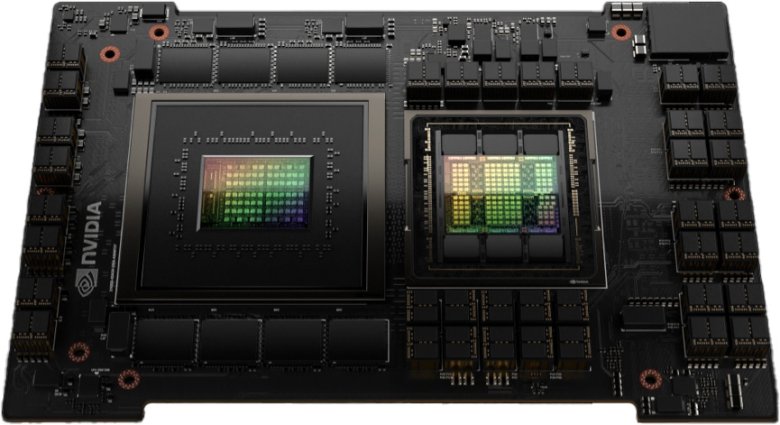

Nvidia uvádí DGX GH200 AI Supercomputer jako 1 EFLOPS řešení. Jenže…

Nejde však o jeden konkrétní superpočítač stavěný na míru pro konkrétního zákazníka, ale standardizovaný produkt pro sériovou výrobu. Prezentován je jako řešení, které dosahuje výkonu 1 EFLOPS. Jenže 1 EFLOPS superpočítačů je na světě pár a rozhodně se taková řešení nevyrábějí sériově. Kde je háček?

Výkon superpočítačů se tradičně uvádí pro univerzální výpočetní výkon při přesnosti FP64 / double-precision. To je v případě Hopper 30 TFLOPS na jedno GPU, takže by k dosažení 1 EFLOPS bylo zapotřebí zhruba 35 tisíc těchto čipů. Což samozřejmě sériově vyráběno nebude. Jak to tedy je?

Aby Nvidia mohla vydat ohromující tiskovou zprávu avizující 1 EFLOPS řešení (AMD má >1 EFLOPS superpočítač v provozu, druhý bude spuštěn letos, Intel spustí Auroru rovněž letos), poněkud přiohla terminologii a čísla. Pokud totiž hodnotu 1 EFLOPS vydělíme v tiskovce uvedeným počtem GPU (256), dostaneme se na údaj 4000 TFLOPS. Při pohledu do naší tabulky umístěné pod odstavcem už jste možná sami přišli na to, že této hodnoty GPU Hopper dosahuje, ale nikoli v univerzálním výpočetním výkonu, nikoli v přesnosti FP64 a nikoli v klasických výpočtech.

| AMD MI250X | AMD MI300 | Nvidia Tesla V100 | Nvidia A100 | Nvidia H100 | ||

|---|---|---|---|---|---|---|

| GPU | Aldebaran | Rigel | GV100 | GA100 | GH100 | |

| architektura | CDNA 2 | CDNA 3 | Volta | Ampere | Hopper | |

| formát | OAM | OAM | SXM2 | SXM4 | SXM5 | |

| CU/SM | 220 | ? | 80 | 108 | 132 | |

| FP32 jader | 14080 | ? | 5120 | 6912 | 15872 16896 | |

| FP64 jader | - | - | 2560 | 3456 | 8448 | |

| INT32 jader | - | - | 5120 | 6912 | 8448 | |

| Tensor Cores | 880 | ? | 640 | 432 | 528 | |

| takt (boost) | 1700 MHz | ? | 1530 MHz | 1410 MHz | 1980 MHz | |

| ↓↓↓ T(FL)OPS ↓↓↓ | ||||||

| FP16 | 383 | ? | 31,4 | 78 | 120 | |

| BF16 | 383 | ? | 39 | 120 | ||

| FP32 | 95,7 47,8 | ? | 15,7 | 19,5 | 60 | |

| FP64 | 47,8 | ? | 7,8 | 9,7 | 30 | |

| INT4 | 383 | ? | ? | ? | ? | |

| INT8 | 383 | ? | ? | ? | ? | |

| INT16 | ? | ? | ? | ? | ? | |

| INT32 | ? | ? | 15,7 | 19,5 | 30 | |

| FP8 tensor | ? | 2000/4000* | ||||

| FP16 tensor | 383 | ? | 125 | 312/624* | 1000/2000* | |

| BF16 tensor | 383 | ? | 312/624* | 1000/2000* | ||

| FP32 tensor | 95,7 | ? | 19,5 | 60? | ||

| TF32 tensor | ? | 156/312* | 500/1000* | |||

| FP64 tensor | 95,7 | ? | 19,5 | 60 | ||

| INT8 tensor | 383 | ? | 624/1248* | 2000/4000* | ||

| INT4 tensor | ? | ? | 1248/2496* | ? | ||

| ↑↑↑ T(FL)OPS ↑↑↑ | ||||||

| TMU | -? | ? | 320 | 432 | 528 | |

| LLC | 16 MB | ? | 6 MB | 40 MB | 50 MB | |

| sběrnice | 8192bit | ? | 4096bit | 5120bit | 5120bit | |

| paměť | 128 GB | 128 GB | 32 GB / 16 GB | 40 GB | 80 GB | 80 GB |

| HBM | 3,2 GHz | ? | 1,755 GHz | 2,43 GHz | 3,2 GHz | 4,8 GHz |

| pam. prop. | 3277 GB/s | ? | 900 GB/s | 1555 GB/s | 2048 GB/s | 3072 GB/s |

| TDP | 500 W 560 W | ? | 300 W | 400 W | 700 W | |

| transistorů | 58,2 mld. | ? | 21,1 mld. | 54,2 mld. | 80 mld. | |

| plocha GPU | 2× ? | 4× ? | 815 mm² | 826 mm² | 814 mm² | |

| proces | 6 nm | 5nm | 12 nm | 7 nm | 4nm | |

| datum | 11. 2021 | 2023 | 2017 | 5. 2020 | 11. 2020 | 2022-23 |

Hodnoty 4000 TFLOPS je dosahováno v přesnosti FP8 (tedy 8× nižší), pouze při tenzorových operacích a pouze při využití tzv. sparse neboli sparsity režimu. Ten lze uplatnit u výpočetních modelů, kde se předpokládá, že polovina dílčích výpočetních výsledků nebude mít na přesnost finálního výsledku příliš zásadní dopad a jako takové jsou tyto výpočty vynechané (proto je výsledný „výpočetní“ výkon dvojnásobný - vzdáleně to může připomínat DLSS).

Jaký tedy bude skutečný výpočetní výkon v jednotkách srovnatelných s ostatními superpočítači? 256 (GPU) × 30 (TFLOPS FP64) = 7680 TFLOPS = 7,68 PFLOS = 0,00768 EFLOPS.