Nvidia vydává RTX Video Super Resolution, zázraky však nečekejte

Umělá inteligence je mocná čarodějka. Potřebuje však vysoký až extrémní výpočetní výkon a má své limity. Když Nvidia začátkem ledna na CES nadhodila, že chystá technologii pro AI-upsampling videa, bylo to vnímáno jako určitá obdoba DLSS určená pro video.

Nutno podotknout, že DLSS navzdory marketingu nestojí v zásadě na AI, která je využívána spíše dílčím způsobem. První generace DLSS byla vyvíjena jako AI algoritmus pro anti-aliasing, což zvládala dobře, ovšem pro posílení marketingové podpory GeForce RTX 2000, která s ohledem na výkon a cenu těchto karet musela být postavena na ray-tracingu (na který výkon těchto karet příliš nestačil) bylo nutné DLSS povýšit na technologii, která bude obraz zvětšovat. K čemuž ale nebyla původně vyvinutá a určená. Výsledkem bylo, že DLSS první generace kvalitativně, výkonnostně i kompatibilitou zvládla konkurence (AMD) překonat s pomocí poměrně jednoduchého algoritmu, který nijak nevyužíval AI a který bylo možné integrovat do libovolné hry za několik hodin.

DLSS druhé generace se tudíž muselo zaměřit na kvalitnější detaily a k jejich získání opět nebyla využita AI, ale temporální algoritmy, tedy data z předchozí vykreslených snímků, s jejichž použitím mohly být rekonstruovány jemnější detaily.

Problém je, že temporální algoritmy, časová složka, nejsou u videa tak snadno a efektivně využitelné jako u renderovaného obrazu, kde jsou hrany a linie ostré, čisté a prosté artefaktů. Video je oproti tomu nerovnoměrně rozostřeno kompresí a plné kompresních artefaktů, což brání tak efektivnímu využití časové složky (předchozích snímků) jaké známe u DLSS 2 (FSR 2 a XeSS).

Je tedy potřeba podstatně více zapojit AI. Existují různé programy využívající AI ke zvětšování fotografií nebo k rekonstrukci videa. Jejich výstupy mohou být velmi úchvatné, ovšem zpracování jedné fotografie si řekne o minuty, desítky minut i hodiny (podle algoritmu, nastavení, rozlišení…). Podobné to je u nástrojů ke zpracování videa, kde je ke zpracování zapotřebí čas i o několik řádů delší než délka přehrávaného videa.

RTX Video Super Resolution se ale o rekonstrukci videa pokouší v reálném čase. Ke zpracování každého snímku má tudíž právě tolik času, kolik zabere jeho přehrání (většinou tedy 0,017-0,033 sekundy). Z toho vyplývají dvě skutečnosti: Aby za takto omezený čas mohl algoritmus s videem něco rozumného provést, musí využít plný výpočetní potenciál grafické karty (což znamená vysoké vytížení GPU a tomu odpovídající spotřebu) a zároveň je stále výpočetní výkon dostupný k real-time zpracování o několik řádů nižší než výkon, který má k dispozici software pro rekonstrukci videa.

Kvalita

Pokud si tyto limity uvědomíme, nemohou výsledky v žádném (negativním ani pozitivním) ohledu překvapit.

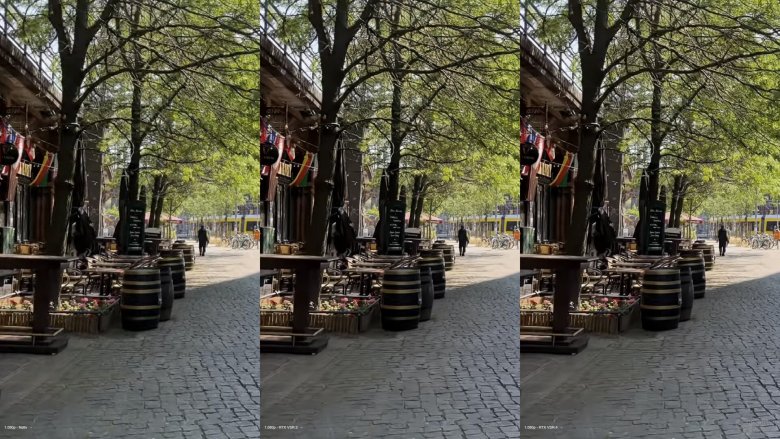

zdroj: ComputerBase

Výše vidíte (vždy zleva): snímek z původního videa, snímek zpracovaný s nastavením VSR 2 a nakonec snímek zpracovaný s nastavením VSR 4. Zpracované snímky mají některé hrany trochu ostřejší, ale nějaké podstatnější zlepšení jemných detailů, jaké známe v herních / 3D algoritmech, se nekoná. Navíc je zde patrný jeden obvyklý neduh známý od dob prvních video post-filtrů: Běžné kompresní algoritmy rozostřují video nerovnoměrně. Pokud na něj pak aplikujeme doostřovací algoritmus, pak zpravidla dojde k zostření těch částí obrazu, které již nějak rozumně ostré byly, ale zcela rozmazané části, kde se algoritmus nemá čeho chytit, zůstávají rozmazané. Výsledkem je tedy zvýraznění kontrastu mezi ostrými a neostrými částmi obrazu, takže výsledek vypadá méně přirozeně než rovnoměrněji neostrý originál.

Redakce webu ComputerBase, která RTX Video Super Resolution zevrubně testovala, v závěru recenze vypíchla následující poznatky:

- Nvidia RTX Video Super Resolution (dále jen VSR) není „DLSS pro video“

- VSR neposune kvalitu 1080p na úroveň 4k (ani 720p na úroveň 1080p)

- posun kvality VSR hodnotí jako „malý pozitivní efekt“ nebo „drobná vizuální zlepšení“

- u výrazněji komprimovaného videa docházelo místy naopak ke zhoršení kvality

- nepřirozený vzhled u listů na stromech s VSR („efekt umělé inteligence“)

Spotřeba

Větším problémem než minimální dopad na vizuální stránku, je spotřeba. Jak již bylo řečeno, při real-time zpracování musí GPU mobilizovat všechny výpočetní prostředky, které má k dispozici, aby mohlo předvést nějaký smysluplný výsledek.

Zatímco GeForce RTX 3050 při běžném přehrávání 1080p60 videa konzumuje zhruba 25-30 wattů, při VSR s kvalitou 4 dosahuje spotřeby až 130 wattů, GeForce RTX 4070 Ti 190 wattů a při 1440p60 videu dokonce 270 wattů, tedy téměř maxima TDP (285 wattů). Při 1080p30 videu dosáhla spotřeba „jen“ 70 wattů (to ale uživatel nemá možnost ovlivnit, neboť snímková frekvence YouTube videa je zpravidla daná a uživatel nemá možnost přepínat). Uživatel může snížit kvalitu VSR s čímž klesne i spotřeba (jenže i ta kvalita, která ani při nastavení na maximum není příliš přesvědčivá).

Mírná a ne vždy pozitivní změna v kvalitě obrazu je tedy vykoupena spotřebou na úrovni plného herního zatížení. Uživatel stolního počítače samozřejmě může akceptovat vyšší hlučnost a účty za elektřinu výměnou za mírné zvýšení kvality (předpokládejme, že Nvidia časem technologii vychytá a ke zhoršení docházet nebude). Nemůže to ale akceptovat uživatel notebooku, kterému by k přehrání filmu nestačila baterie.

Ukázky Nvidie, které prezentovala na CES (srovnejte s reálnými screenshoty výše)

Nvidia dodržela slovo, které padlo na CES a vydala RTX Video Super Resolution v únoru. Zásadní otázkou, na kterou však neznáme odpověď, je, zda je výsledek takový, jaký si Nvidia slibovala, zkrátka jestli bylo dosaženo cíle. Na tom záleží, jestli v blízkých měsících může dojít k nějakému podstatnému zlepšení, nebo je stávající situace v podstatě definitivní. V prvním případě by byla naděje k nějakému zlepšení, v druhém nelze čekat, že si RTX Video Super Resolution najde publikum. Lze totiž směle pochybovat, že by ve slepém testu většina uživatelů poznala rozdíl VSR oproti mírnému popotažení položky „sharpness“ pro video, které - oproti VSR - nemá vliv na spotřebu.