188GB HBM3 Nvidia H100 NVL vznikla na míru pro Chat-GPT

Nvidia loni uvedla akcelerátory Hopper ve dvou základních podobách. Jednak jako SXM5 moduly a jednak jako PCIe karty. Jako obvykle dosahuje SXM5 varianta vyššího výkonu i TDP, neboť je na modulu podstatně více prostoru pro velký radiátor chladiče. Nová varianta označená jako NVL má však opět podobu PCIe karty, respektive karet. Nvidia H100 NVL jsou totiž dvě PCIe karty spojené můstkem NVLINK. Nejde však o původní H100 PCIe. Nvidia k tomuto řešení sáhla patrně pro vyšší výpočetní denzitu takového řešení. Zkrátka méně prostoru zabraného chladičem ~ prostor pro více GPU. Jak vyplývá z parametrů, energetická efektivita má být 2× vyšší (2× více výkonu při stejném TDP díky dvojici karet s TDP polovičním oproti SXM5 provedení). Lze však očekávat, že realita bude trochu níže, protože reálné a papírové takty se budou patrně nezanedbatelně lišit.

| Nvidia A100 | Nvidia H100 | ||||

|---|---|---|---|---|---|

| GPU | GA100 | GH100 | 2× GH100 „NVL“ | ||

| architektura | Ampere | Hopper | |||

| formát | SXM4 | SXM5 | PCIe | 2× PCIe | |

| CU/SM | 108 | 132 | 114 | 2× 132? | |

| FP32 jader | 6912 | 15872 16896 | 14592 | 2× 16896? | |

| FP64 jader | 3456 | 8448 | 7296 | 2× 8448? | |

| INT32 jader | 6912 | 8448 | 7296 | 2× 8448? | |

| Tensor Cores | 432 | 528 | 456 | 2× 528? | |

| takt | 1410 MHz | 1980 MHz | 1750 MHz | 1980 MHz? | |

| ↓↓↓ T(FL)OPS ↓↓↓ | |||||

| FP16 | 78 | 120 134 | 102 | 2× 134 | |

| BF16 | 39 | 120 134 | 102 | 2× 134 | |

| FP32 | 19,5 | 60 67 | 51 | 2× 67 | |

| FP64 | 9,7 | 30 34 | 26 | 2× 34 | |

| INT4 | ? | ? | ? | ? | |

| INT8 | ? | ? | ? | ? | |

| INT16 | ? | ? | ? | ? | |

| INT32 | 19,5 | 30 34 | 26 | 2× 34 | |

| FP8 tensor | 1979/3958* | 1513/3026* | 2× 1979/3958* | ||

| FP16 tensor | 312/624* | 989/1979* | 757/1513* | 2× 989/1979* | |

| BF16 tensor | 312/624* | 989/1979* | 757/1513* | 2× 989/1979* | |

| FP32 tensor | 19,5 | 60? 67? | 51? | 2× 67? | |

| TF32 tensor | 156/312* | 495/989* | 378/757* | 2× 495/989* | |

| FP64 tensor | 19,5 | 67 | 51 | 2× 67 | |

| INT8 tensor | 624/1248* | 1979/3958* | 1513/3026* | 2× 1979/3958* | |

| INT4 tensor | 1248/2496* | ? | ? | ? | |

| ↑↑↑ T(FL)OPS ↑↑↑ | |||||

| TMU | 432 | 528 | 456 | 2× 528 | |

| LLC | 40 MB | 50 MB | 2× 50 MB? | ||

| sběrnice | 5120bit | 5120bit | 6144bit | ||

| paměť | 40 GB | 80 GB | 80 GB | 2× 94 GB | |

| HBM | 2,43 GHz | 3,2 GHz | HBM3 5,23 GHz | HBM2E 3,2 GHz | HBM3 5,1 GHz |

| pam. prop. | 1555 GB/s | 2048 GB/s | 3350 GB/s | 2048 GB/s | 2× 3,9 TB/s |

| TDP | 400 W | 700-800 W | 350 W | 700 W | |

| transistorů | 54,2 mld. | 80 mld. | 2× 80 mld. | ||

| plocha GPU | 826 mm² | 814 mm² | 2× 814 mm² | ||

| proces | 7 nm | 4nm | |||

| datum | 5. 2020 | 11. 2020 | 2022? | H2 2023 | |

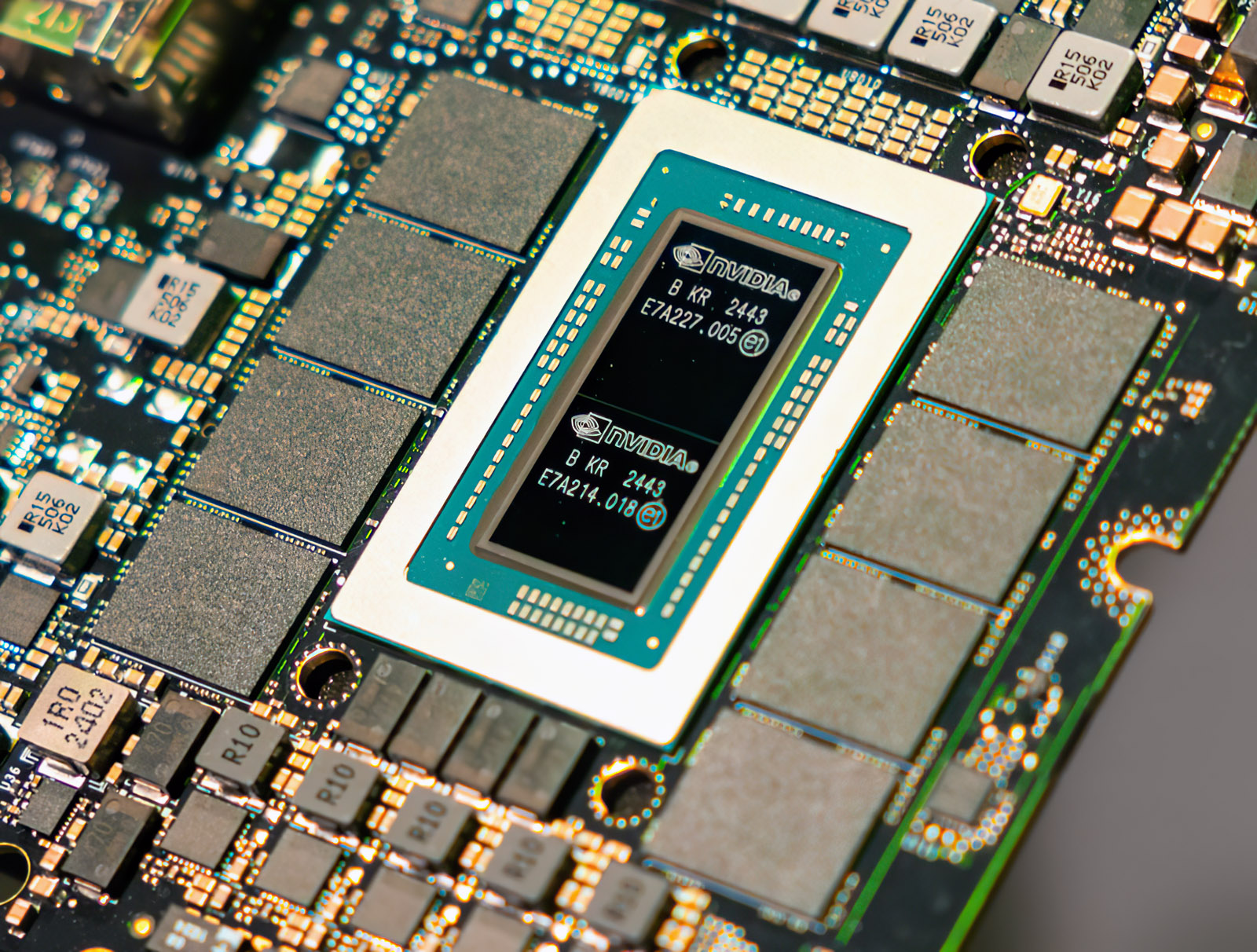

Protože jsou jazykové modely Chat-GPT velké, osadila Nvidia poprvé GPU GH100 všemi šesti HBM moduly (tzn. plně využila 6144 bit sběrnici) a použila navíc HBM3 (oproti HBM2E na původní PCIe variantě). To by teoreticky odpovídalo 6× 2× 16 GB = 192 GB paměti, jenže reálně specifikace uvádí 188 GB. Jak toho lze dosáhnout, když žádné 15,66GB moduly HBM neexistují? Nvidia se nejspíš dohodla s některým výrobcem pamětí, který jí dodává moduly s deaktivovanými vadnými buňkami, což by mohlo znamenat mírně nižší kapacitu, ale i podstatně výhodnější cenu.

Přestože Nvidia hovoří o vydání H100 NVL, reálně mají být tyto akcelerátory dostupné někdy ve druhém pololetí letošního roku.