AMD PowerTune versus Nvidia GPU Boost - druhý pohled

Kapitoly článků

Jak funguje Nvidia GPU Boost

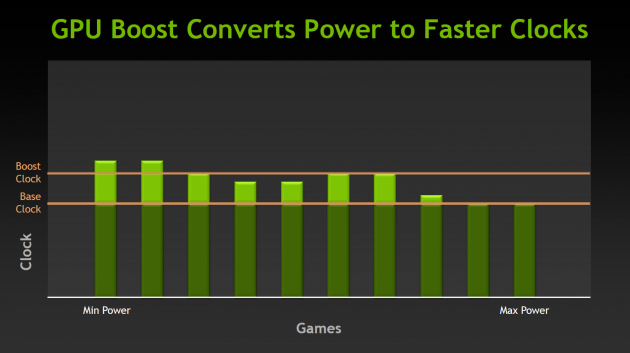

I když se GPU Boost z hlediska uživatele tváří jako automatické přetaktování, reálně je základní cíl technologie podobný jako u PowerTune: Efektivně využít TDP limity a ochránit kartu před poškozením.

Problém je stejný, řešení odlišné. V první řadě je nastavena jako základní minimální frekvence a pokud není dosaženo TDP nebo kritických teplot, GPU se přetaktovává. Druhý rozdíl spočívá v tom, že není monitorováno vytížení GPU jako takového, ale dochází k analogovému měření proudů a teplot v rámci napájecích obvodů a podle těch je upravována frekvence a napětí GPU.

Tento systém je podstatně jednodušší a přímočařejší, což má své výhody i nevýhody. Jedním z důsledků, který vnímáme jako nevýhodu, je odlišný výkon různých kusů karet v závislosti na dobrém či horším kusu a v závislosti na teplotě, při které karta operuje. Pokud recenzent testuje kartu ve volně ložené základní desce ve větrané místnosti, bude mít výsledky výkonu lepší než zákazník, kterému uzavřená skříň stojí ve vytopené místnosti.

Pokud jste procházeli všechny recenze, mohli jste vypozorovat, že některé karty (včetně vzorku, který jsme testovali my) běžely ve většině aplikací při frekvenci přes 1100 MHz, většina karet fungovala mezi 1050-1100 MHz a některé kusy se držely lehce pod 1150 MHz. Preventivně předesílám, že tím nechceme naznačit, že by nám Nvidia podsunula nějaký lepší vzorek (osobně jsem byl přitom, když byl náhodně vybrán jeden z hromady), jen ukazujeme, že se skutečně výsledky mohou kus od kusu a sestavu od sestavy lišit.

Rozdíly mezi GPU Boost a starým a novým PowerTune

Nyní se vracíme k tomu, čím se jmenované technologie liší a asi bude nejpřehlednější, pokud si to shrneme do tabulky:

|

GPU Boost (GTX 680) |

PowerTune (HD 6900) |

PowerTune (HD 7000) |

|

|---|---|---|---|

| monitoring |

analogový (teplota, proud) |

digitální (zátěž GPU) |

|

| reakční doba | ~100000 µs | ? | ~1 µs |

| minimální krok | ~13 MHz | ~13 MHz | ~1 MHz |

Nedokážeme v tuto chvíli říct, zda AMD nějakým způsobem prostřednictvím ovladačů neimplementovala novější verzi PowerTune i Radeonu HD 6900, ale předpokládejme, že ne. Původní PowerTune byl schopný upravovat frekvenci pouze v násobcích cca 13 MHz, což AMD vyhodnotila jako nedostačující (může to souviset se vznikem microstutteringu - tedy zhoršené plynulosti v toku snímků).

GPU Boost aktuální stav karty monitoruje a upravuje řádově po stovkách milisekund, tedy asi 10× za vteřinu. Pokud upravuje frekvenci, je nejmenší krok roven 13 MHz (případně násobkům 13 MHz), jako tomu bylo u původního PowerTune.

Nová verze PowerTune oproti tomu dokáže frekvenci měnit po jednotkách MHz a to i po jednotlivých mikrosekundách, takže nevytváří 10 frekvenční skoků za vteřinu, ale je schopna (pokud by to bylo potřeba) ve zlomku vteřiny vytvořit plynulý přechod z aktuální na požadovanou frekvenci.

Právě vysoká reakční doba v případ GPU Boost je důsledkem analogového měření. Problém nebude v tom, že by řádově 100 ms byl příliš dlouhý čas pro reakci na kritický stav karty (power virus, který by kartu odrovnal během 100 ms skutečně známý není), ale spíš v dlouhém intervalu, přes který jsou prováděny úpravy taktu ve 13MHz násobcích. Praktický dopad pozorovala redakce TechReport v Batman: Arkham City, kdy se v průběhu hry objevoval microstuttering s až 180ms propady (tzn. že zhruba na pětinu vteřiny se hra zastavila a poté pokračovala dál, viz graf výše). To ukazuje, že 100ms reakční interval může být problematický, byť Nvidia s ohledem na Batman: Arkham City přislíbila řešení v ovladačích. Pro lepší představu doby 100 ms si můžete představit, že jde o čas, za který GPU při 60 FPS vykreslí 6 snímků.

metodika 99th percentile odráží nejen framerate, ale také lagy a microstuttering

- zdroj: TechReport -

TechReport se právě na stuttering a lagy ve svých recenzích zaměřuje dvěma způsoby (určením času, kdy karta přes 50 milisekund nevykreslila jediný snímek a měřením nejdelších intervalů mezi jednotlivými snímky).

AMD (e-mail), RealWorldTech, TechReport