Minirecenze: Gigabyte R282-Z92 A00 server - dva AMD EPYC Milan procesory v akci

Kapitoly článků

Po nedávné skupince dvousocketových DELL serverů tu máme modernější Gigabyte server s dvěma AMD SP3 sockety, který je navíc připravený pro nové AMD EPYC Milan procesory založené na Zen3 architektuře a 7nm TSMC procesu. I tento server se stal tak trochu obětí času, konkrétně trpěl na nedostatek mého času a nutností počítat nějaké věci v jiné fyzické lokaci. Proto chybí některé testy, ale většinu jsem stihnul. Zároveň musím opakovat, že testování serverů je poměrně ošemetné, většinou se staví servery pro konkrétní nasazení, takže konfigurace se mezi sebou značně liší a nemusí být vždy optimální z hlediska maximalizace výkonu. To je i případ dnešního kousku, který byl sestaven na nějaké specifické použití, o kterém nemohu mluvit, ale pro samotnou minirecenzi to není důležité.

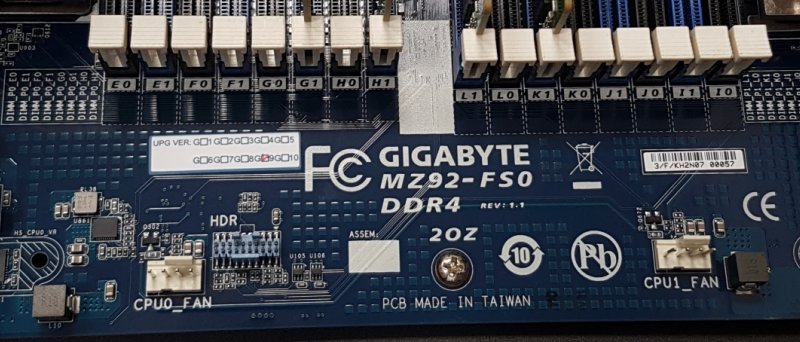

Gigabyte R282-Z92 A00 je pořádný 2U server s hromadou 2,5" hot swap slotů, PCIe slotů a tak podobně. Rozměry výrobce udává jako 438 x 87 x 730 mm, přičemž hmotnost se pohybuje někde v rozpětí 18-25 kg v závislosti na tom, jaké komponenty jsou osazeny uvnitř serveru. Gigabyte R282-Z92 A00 je refresh staršího serveru R282-Z92 100, který je v podstatě identický, ale nepodporuje nejnovější AMD EPYC Milan procesory, umí jen první EPYCy Naples a druhou generaci EPYC Rome. Dnes testovaný kousek pro změnu nepodporuje první generaci AMD EPYC procesorů, fungují zde pouze generace EPYC Rome(Zen2) a Milan(Zen3).

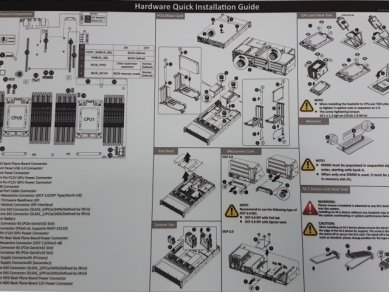

Krabice je dostatečně robustní a tradičně najdeme samotný server v igelitovém obalu a pěnových vycpávkách, aby se po cestě nepoškodil. V krabici najdeme i KingSlide kolejnice pro montáž do racku. Následuje drobotina jako manuál, či GPU kabely, nebo i něco dalšího, co Vám dodavatel k serveru přiloží.

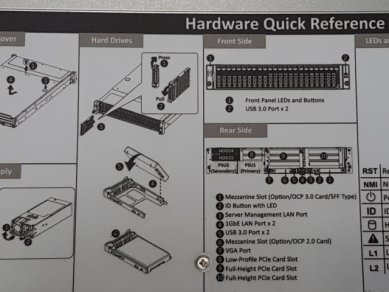

Na přední části serveru můžeme vidět několik LEDek(napájení, UID, aktivita dvou onboard sí/tovek, aktivita disku, error LEDka) a zapínací tlačítko. Nechybí zde i dva USB-A 5Gb/s porty.

Celý předek serveru pak zabírá celkem dvacet čtyři hot-swap šachet na 2,5" disky, server má backplane s hromádkou U.2 konektorů a umí tak obsloužit klidně i 24 PCIe NVMe 2,5" disků v NVMe U.2 2,5" provedení. Zároveň neí problém osadit i klasické SAS disky. Deska má nějaké U.2 porty přímo na desce, ale pokud chcete všechny NVMe disky připojit do CPU, potřebujete hromádku Gigabyte NVMe riser karet, které fyzicky mění standardní PCIe slot na SASové konektory, s potřebnými SAS kabely pak propojíte backplane s disky a je hotovo.

Pokud však plánujete použít nějaký hardwarový RAID kontrolér, backplane jednoduše připojíte za pomoci miniSAS kabelů přímo do něj.

Na horní části serveru najdeme dlouhý lepík, který popisuje některé základní prvky serveru a to včetně demontáže zdrojů a disků.

V zadní části serveru můžeme vidět dva 2,5" SATA/SAS šuplíky, toto řešení jsem viděl i na mnohých 2U Supermicro serverech, jedná se o užitečné řešení, kdy si vystačíme s dvěma SAS SSD v RAID1 pro systém a přední pozice pak obsluhují nějaké jiné úložiště.

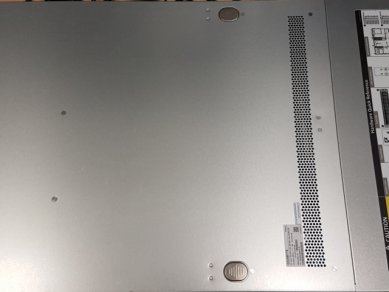

Ve spodní části jsou dva napájecí zdroje, samozřejmě plně redundantní. Každý ze zdrojů umí dodat až 1600 Wattů, přičemž má specifikaci 80PLUS Platinum, jak je u serverů již delší dobu zvykem, co nejvyšší účinnost je zde extrémně důležitá. Zdroje mají jednu 12V 133A větev a 12Vsb 2,5A větev. Všechna nižší napětí jako 5V, 3,3V pak zařizují DC-DC měniče na základní desce.

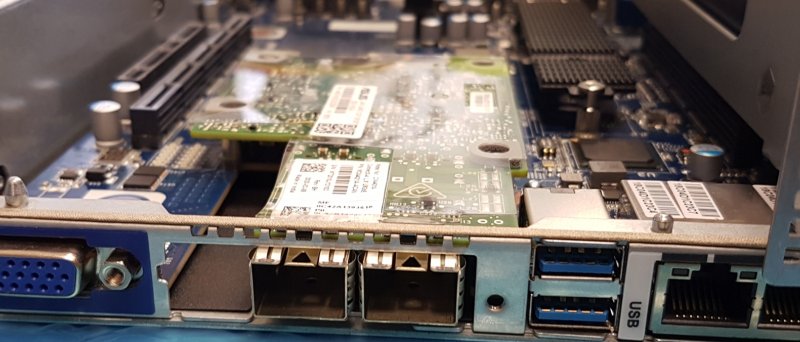

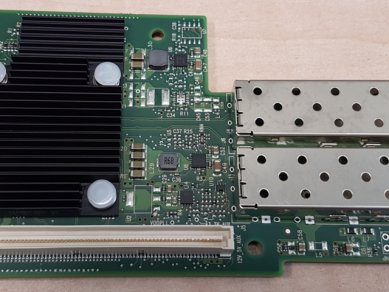

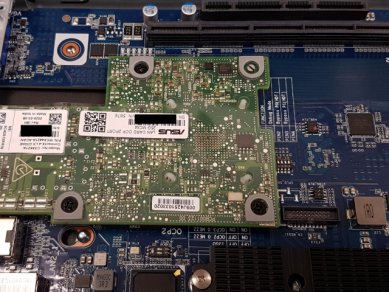

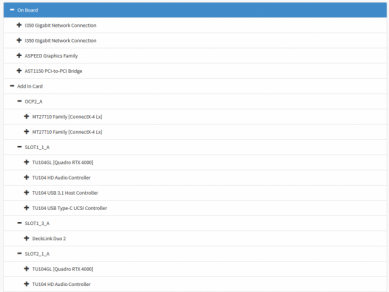

Vedle zdrojů a zcela na spodku můžeme vidět konektivitu, kterou poskytuje samotná základní deska. Najdeme zde klasický 19-pin D-Sub konektor, nebo VGA pokud chcete. Ten je samozřejmě připojen do 2D zobrazovače ASPEED AST2500, který je součástí BMC. Vedle VGA najdeme OCP 2.0 slot pro přídavné síťové karty, ten by měl nabídnout až osm PCIe Gen3 linek a typicky se používá pro všelijaké síťové karty. V našem případě zde sedí OCP karta od ASUSu, která má na sobě Mellanox Connect-X 4 2x SFP28 25Gb/s chipset. Výhodou těchto OCP slotů je to, že nám takto síťové karty "nežerou" velké PCIe sloty. Server původně obsahoval PCIe 2x SFP+ kartu od Intelu, ale dostal upgrade na 2x SFP28, což je docela pěkný upgrade.

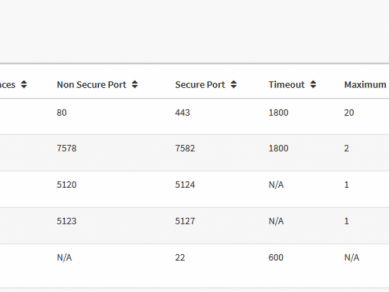

Vedle OCP 2.0 slotu najdeme dva USB-A 5Gb/s porty, dva gigabitové RJ45 ethernety, které poskytuje chipset Intel i350 a třetí RJ45 připojený přímo do BMC pro vzdálenou správu. Vedle tohoto RJ45 pak najdeme ID tlačítko, které svítí po stisknutí modře vpředu i vzadu serveru a slouží pro snadnou identifikaci v racku, což se hodí, pokud zde máte několik stejných serverů. Výbavu zakončuje OCP 3.0 slot, který nabízí šestnáct PCIe Gen3 linek, což mne poněkud překvapilo, jelikož třeba takový DELL R6525 má OCP s šestnácti Gen4 linkami. Buď má Gigabyte ve svých materiálech chybu, nebo je slot opravdu jen Gen3.

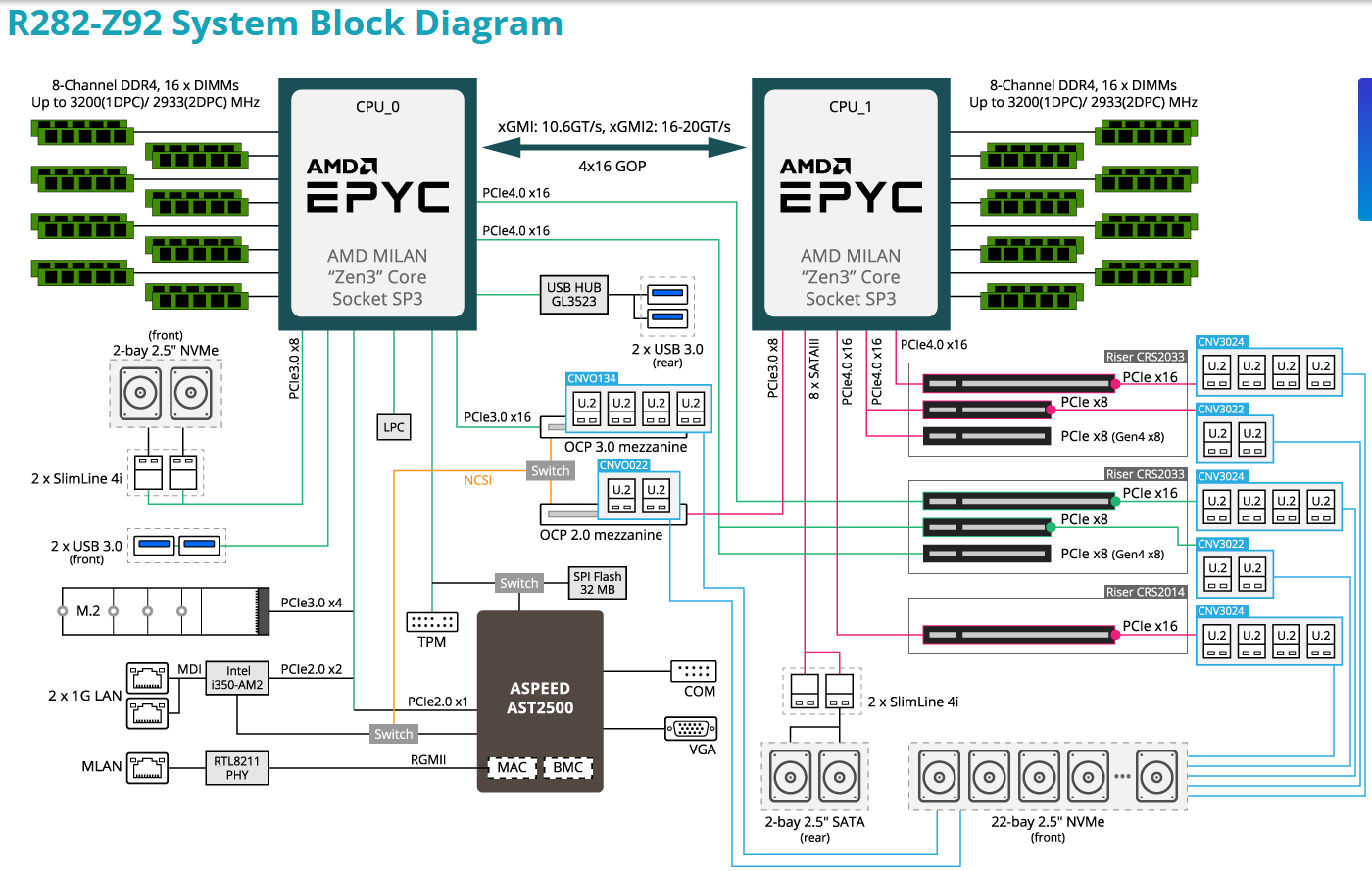

Nesmím samozřejmě zaponenout na celkových osm PCIe slotů, to je něco, z čeho mám u serveru velkou radost, jelikož PCIe slotů není nikdy dost, obzvlášť když chcete nějaké ty kartičky přidat. Pro nadšence zde přidám ještě diagram zapojení všech sběrnic ze stránek Gigabyte a hurá na prohlídku vnitřností serveru!

Po odklopení horního víka serveru zjistíme, že se vlastně jedná o zjednodušený manuál, na spodní části víka najdeme hromádku diagramů ohledně komponent v serveru.

V přední části serveru, hned za NVMe backplane pro přední disky najdeme sadu čtyř 80mm ventilátorů vedle sebe, jedná se o Delta PFM0812HE-01 ventilátory, které se umí točit pekelně rychle, až 16300 RPM při odběru 84 Wattů. Ventilátory dosahují průtoku vzduchu až 129 CFM při hlučnosti 77 děloBuchů.

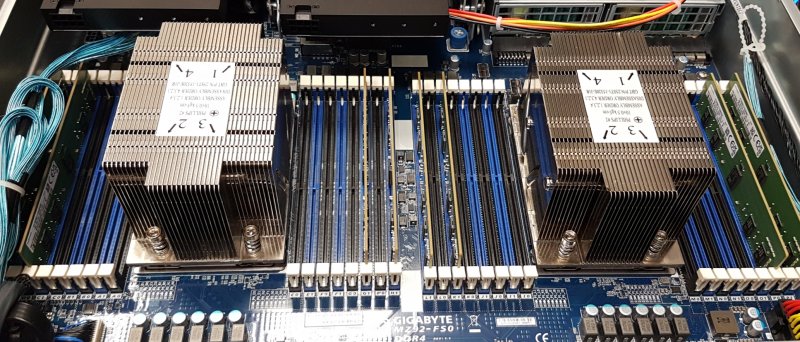

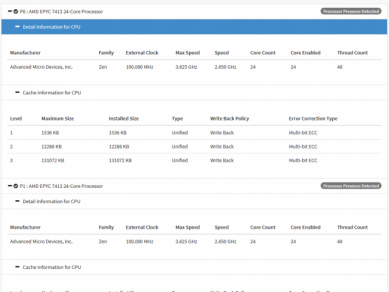

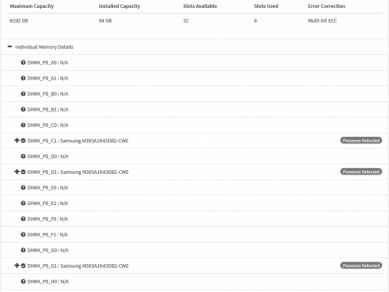

Za ventilátory najdeme plastovou krytku, která usměrňuje tok vzduchu skrze chladiče procesorů a paměti. Server má celkem 32 slotů pro DDR4 Registered ECC paměti, každý procesor tak má k dispozici šestnáct slotů a můžeme tak využít osmikanálové zapojení pamětí.

Specialitkou tohoto serveru je to, že umí provozovat 3200 MT/s propustnost RAM i při 2DPC zapojení, ale musí se to speciálně zapnout v BIOSu a očekávám, že to nejspíše zvyšuje celkovou spotřebu. Pokud osadíme 256GB moduly, celková kapacita se vyšplhá na 8 TB RAM. Testovaná konfigurace ale není optimalizovaná na co nejvyšší množství paměti, spíše naopak. Každý procesor má jen čtyři single-rank 8GB DDR4-3200 Registered ECC moduly. Na to co server dělá je to dostatečné, samozřejmě z hlediska výkonu by bylo lepší osadit třeba osm 16GB dual-rank pamětí pro každé CPU, ale na to jednoduše nedošlo. I z tohoto důvodu je výkon v některých testech nižší.

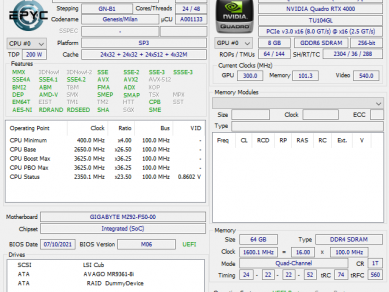

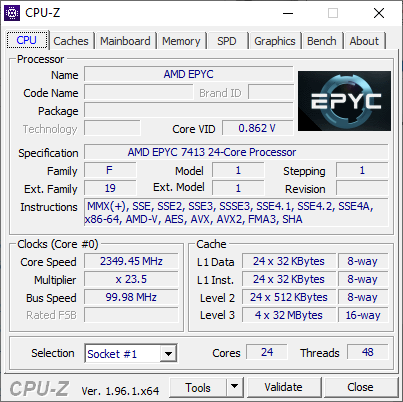

Pod masivními chladiči bydlí procesory AMD EPYC 7413, jedná se o 24C/48T Zen3 kousky se základním taktem 2,65 GHz a Turbo boostem až 3,6GHz. Procesory si mezi sebou povídají za pomoci sběrnice Infinity Fabric a to ve formě 64 PCIe Gen4 linek, nicméně celkově tato platforma nabízí 128 PCIe Gen4 linek, 64 z každého CPU. Procesory mají konfigurovatelné TDP, na výběr je 165 nebo 200 Wattů, v testovaném serveru běžely a běží v 200W konfiguraci. Server samotný přitom údajně podporuje až 280W TDP CPU. Zajímavé je, že procesory udrží frekvenci okolo 3,4GHz při využití všech jader, což není vůbec špatné.

Trochu mne překvapilo, že napájecí kaskáda na desce postrádá nějaké pasivní chladiče, nicméně jedná se o první komponenty na ráně ventilátorů, takže ofuk v klimatizované místnosti bude nejspíše dostatečný, napájecí kaskáda nijak brutálně netopí i přes absenci pasivních chladičů.

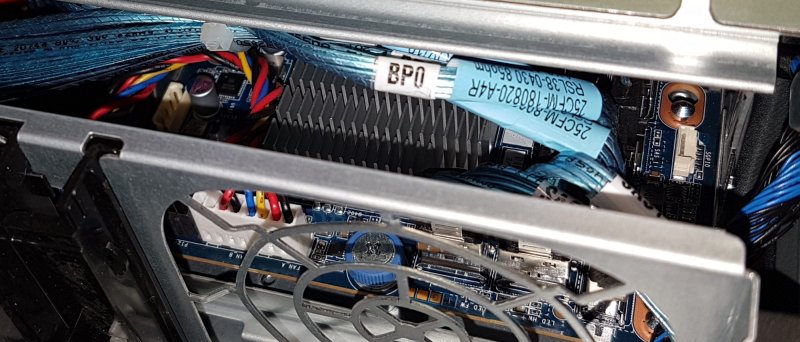

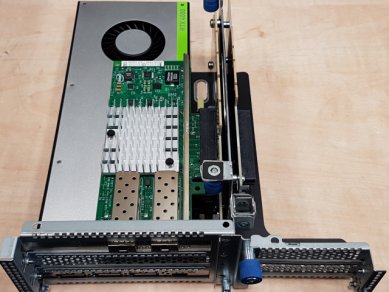

Nyní něco málo k PCIe slotům, celkem jich je v serveru osm a poskytují je tři PCIe stromečky. Všechny tyto standardní sloty jsou PCIe čtvrté generace. Nejblíže ke koši s dvěma SAS/SATA 2,5" rámečky najdeme dva PCIe Gen4 x8 sloty typu low-profile, což je vhodné pro různé síťové karty a řadiče. Později jsem do těchto slotů přestěhoval RAIDovou kartu MegaRAID 9361-8i a také její BBU.

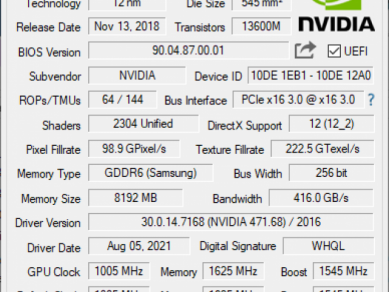

Dále zde najdeme šest slotů plné výšky, tři jsou vždy v konfiguraci x16x8x8, tedy můžeme osadit pouze dvě PCIe x16 karty, ostatní sloty jsou jen x8, ale všechny jsou PCIe Gen4. Jak můžete vidět z fotografií, v serveru jsou osazeny dvě jednoslotové PCIe x16 grafické karty, jedná se o dvě PNY NVIDIA Quadro RTX 4000 8GB karty, které vyžadují i nějaké to přídavné napájení, to je řešeno za pomocí standardních PCIe osmipinů, nicméně druhý konec kabelu využívá Gigabyte proprietární osmipin ze základní desky.

Na samotné desce pak najdeme dva OCP sloty, které jsou přístupné zvenku serveru, jeden M.2 22110 slot pro PCIe NVMe SSD včetně chladiče a několik napájecích konektorů pro GPU či klec s 2,5" disky.

Co se týká úložiště, v serveru bylo osazeno šest Samsung PM883 1,92TB SATA 6Gb/s SSD, připojeny byly do karty MegaRAID 9361-8i a nakonfigurovány v RAID5. Jako operační systém sloužil Windows Server 2019 Essentials a aktuálními aktualizacemi, později ještě Ubuntu 21.04. Ovladače jsem použil vždy od výrobce, tedy pro chipset, ASPEED AST2500 a onboard síťovky jsem použil ovladače ze stránek Gigabyte, pro OCP Mellanox kartu ovladače ze stránek Mellanoxu, pro NVIDIA RTX 4000 jsem využil nejnovější Quadro ovladače pro Windowsí server.

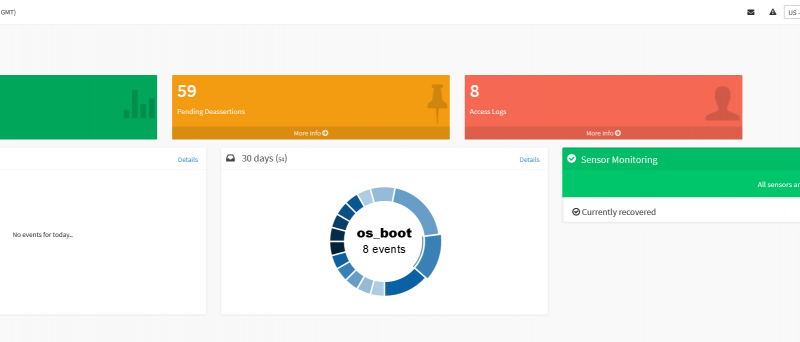

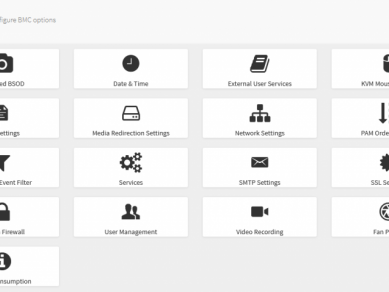

GIGABYTE Management Console - BMC - IPMI

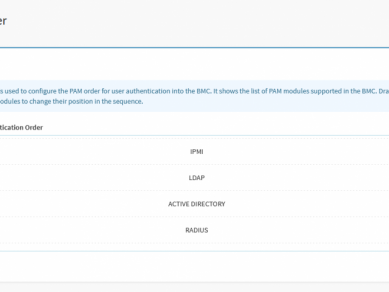

Na serveru nesmí chybět i nějaká forma vzdálené správy, ASPEED AST2500 je velmi častý a známý čip. Většina výrobců své BMC/IPMI rohraní upravuje a doplňuje o další funkce. Gigabyte se například chlubí explicitní podporou Broadom MegaRAID adaptérů v rámci jejich rozhraní. A najdeme zde i nějaké další funkce, které nejsou tak úplně běžné u jiných výrobců serverů. Gigabyte nabízí i funkci a službu GSM(Gigabyte Server Management), což může být užitečné pro hromadnou správu více serverů, včetně připojení na telefon. To může být pro některé adminy zajímavé, nebo spíše dokonce i děsivé.

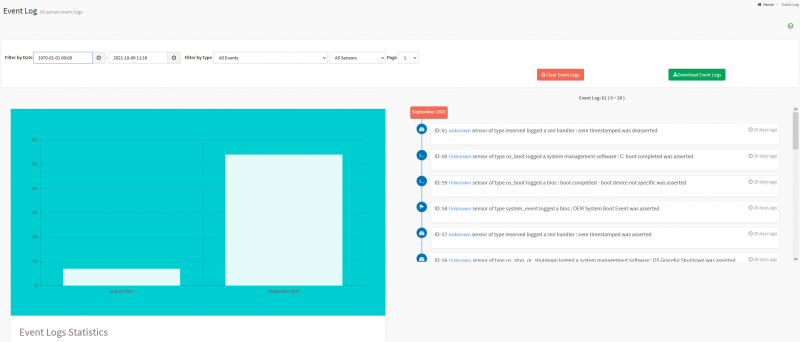

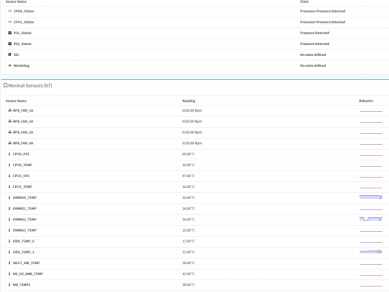

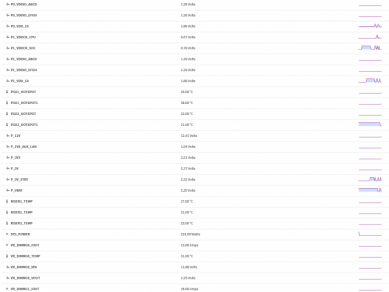

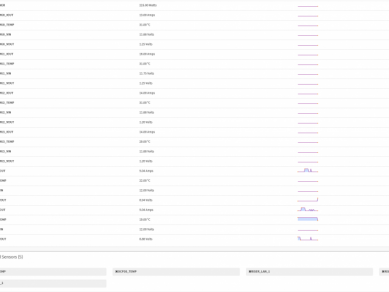

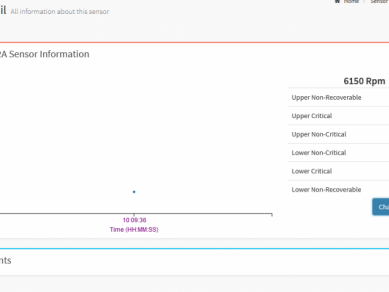

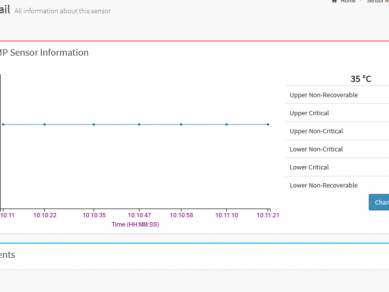

Já jsem primárně řešil jen samotné BMC/IPMI rozhraní v rámci serveru, jak dobře funguje či nefungje hromadná správa nedovedu říct, jelikož jsem to netestoval. Webové rozhraní působí moderněji, než starší verze RedFishe, přičemž zde najdeme standardní věci jako monitoring různých senzorů, nastavení sítě, posílání alarmů a tak podobně. Zajímavé je, že všechny senzory logují poměrně detailně svůj stav a u mnohých můžeme manuálně změnit vysoké či nebezpečné hodnoty.

IPMI nám i ukáže jaké procesory, paměti a PCIe karty máme nainstalované, což je opět standardní funkce.

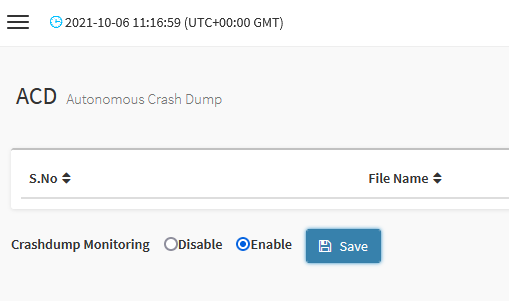

Zajímavá je i funkce ACD, což je novinka, tato funkce by měla umět monitorovat stav běžícího OS a logovat co se dělo při pádu OS. Teoreticky tak můžeme snadno zjistit, proč Windows padl do BSOD. BSOD jsem vyvolat nezkoušel, všiml jsem si této volby skoro až ke konci.

V nastavení najdeme mnoho dalších standardních voleb, včetně nastavení HTML5 konzole, služeb, uživatelů, zabezpečení a tak podobně.

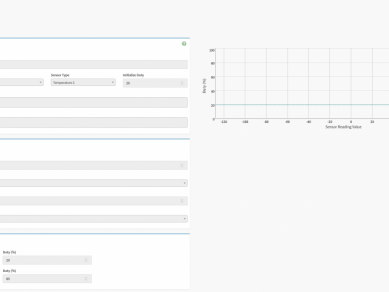

Zajímavé jsou profily ovládání otáček ventilátorů, můžeme zde přenastavit podle čeho se ventilátory řídí a jak se mají chovat. Můžeme dokonce nastavit každý jednotlivý ventilátor a to celkem detailně. Zdrojů teploty může být více, přičemž v továrním nastavení se vychází z teploty procesorů pro každou dvojici ventilátorů. V Gigabyte si dokonce připravili kupu profilů pro různé grafické karty, což může být užitečné, pokud plánujete vytěžovat hlavně GPU, v případě vytížení jen GPU se totiž ventilátory v továrním nastavení budou flákat a to dává prostor grafickým kartám k přehřívání.

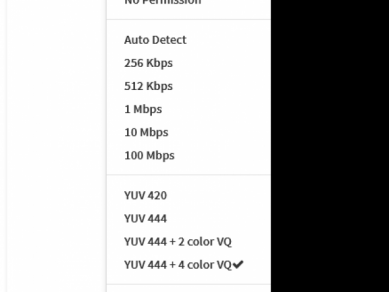

HTML5 konzole je pak standardní, cením si zde možnosti snadno připojit ISO nebo možnost změnit kvalitu obrazu, ne všechny HTML5 KVM toto umí.