Arzenál Pascalu se neomezuje na 16, 32 a 64bit výpočty, zvládá i 8bit

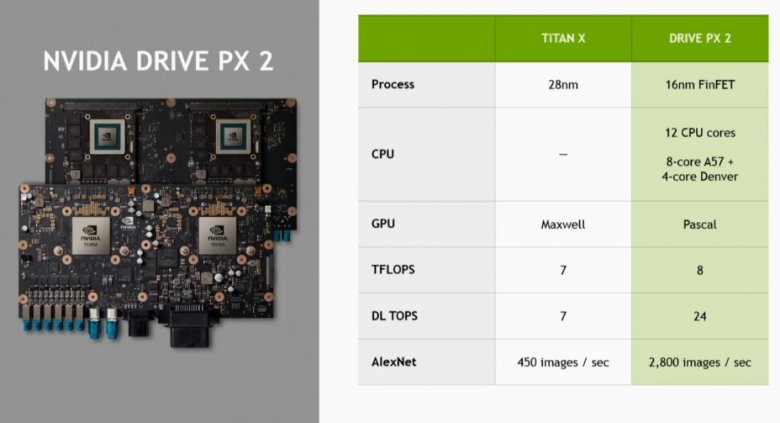

Zvlášť zajímavé je to s ohledem na fakt, že souhrnný výkon v TFLOPS se oproti Titanu X výrazně lišit nemá - Titan X dosahuje 7 TFLOPS, modul Drive PX2 s jádry Pascal a ARM procesorem dosahuje 8 TFLOPS. Jenže zatímco Titan X dosahuje taktéž 7 DL TOPS, v případě Drive PX2 jde o 24 DL TOPS:

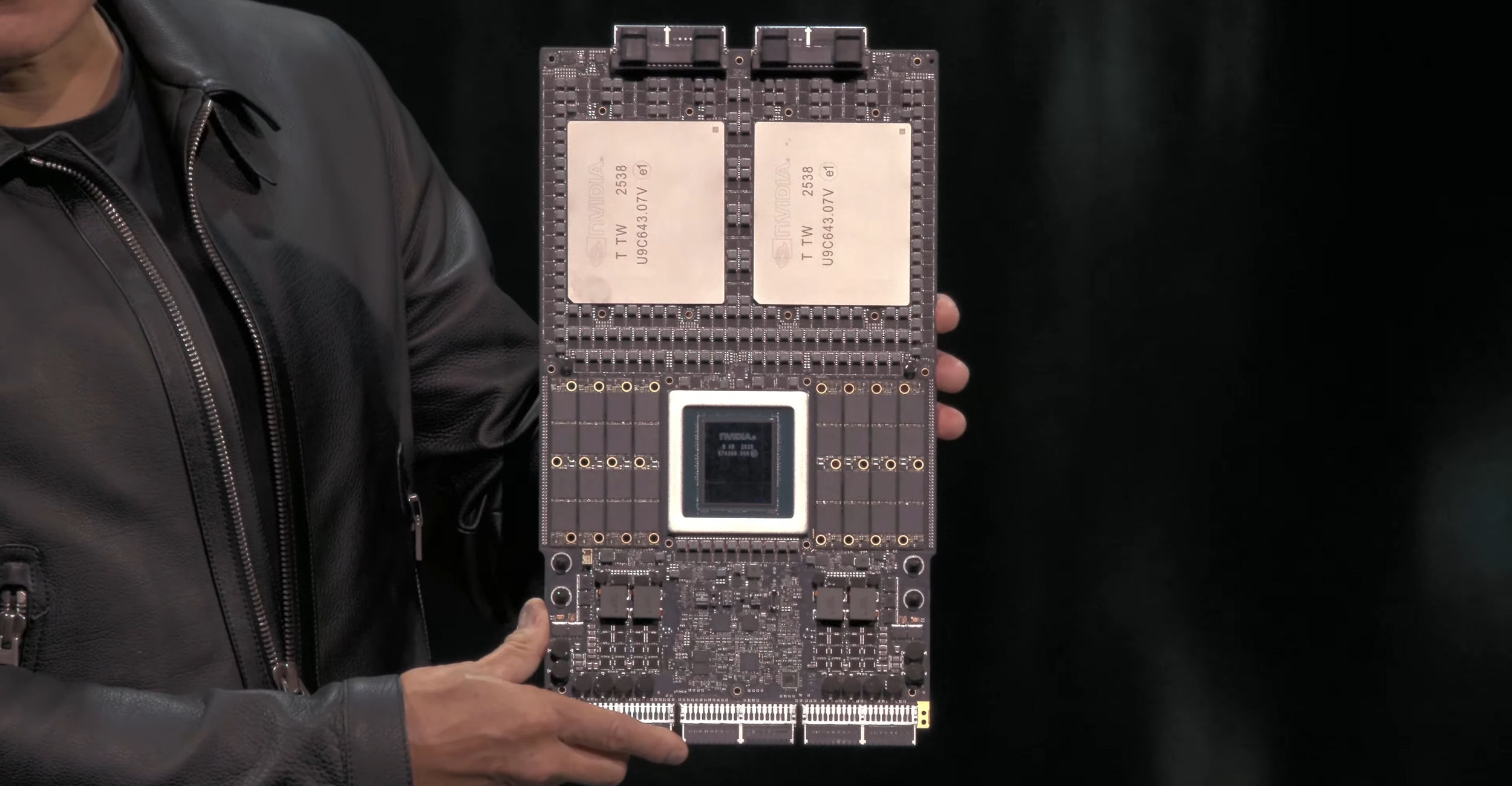

Na slajdu nás mohou zaujmout dvě věci: model Pascalu vytvořený z desky, do níž jsou zasunuté dvě mobilní moduly GeForce GTX 980M s jádry Maxwell („pilka a vruty 2.0“) a dále údaj hovořící o „24 DL TOPS“

Co to znamená a odkud se rozdíl bere? Zkratka DL TOPS znamená Deep Learning Tera OPS, respektive Deep Learning Trillions of Operations Per Second. Deep Learning je metoda strojového učení a jednotky jsou biliony operací za sekundu. Nvidia často v souvislosti s Pascalem a umělou inteligencí hovořila o použití half-precision, tedy poloviční přesnosti FP16, kterou bude Pascal zvládat 2× rychleji než standardní FP32, díky čemuž bude mít dvojnásobný náskok před stávajícím Maxwellem, na které je postavený Titan X.

Jenže 2× vyšší výkon stále nevysvětluje číslo, které je více než 2× vyšší. Údaje začaly dávat smysl teprve když se ukázalo, že architektura Pascal nebude podporovat pouze FP64 (double-precision), FP32 (single-precision) a FP16 (half-precision), ale také Int8, tedy celočíselné výpočty s osmibitovou přesností. Ty, ač jsou pro drtivou většinu grafických operací z důvodu nízké přesnosti nepoužitelné, pro určité typy výpočtů strojového učení stačí. Pascal by měl podporovat FP64:FP32:FP16:Int8 v poměru 1:2:4:8, tedy Int8 výpočty při výkonu 4× vyšším než standardní FP32. Že v tabulce nejde právě o čtyřnásobek je způsobeno patrně tím, že do celkových hodnot je zahrnut i výpočetní výkon procesorových jader, který ovšem na podpoře Int8 přesnosti GPU generace Pascal nic nemění.

foto: Anandtech