Nvidia GPU Boost - do třetice (aktualizováno)

Na situaci se znovu podíval Damien Triolet ze serveru Hardware.fr, který už v rámci recenze GeForce GTX 680 vyjádřil určité pochybnosti o způsobu, jakým technologie funguje. Pokusil se nejasnosti konzultovat s Nvidií, ale odpovědí mu bylo, že společnost nechce zveřejňovat informace o kvalifikačním procesu, protože by se na jejich základě mohla inspirovat konkurence. Budiž (byť AMD věděla o principu fungování GPU Boost již v den vydání Kepleru, kdy nás informovala o rozdílech mezi GPU Boost a vlastním PowerTune).

O co jde tentokrát: Při prezentaci Kepleru v San Franciscu padl při promítání výše uvedené stránky z prezentace dotaz, zda je frekvence GPU Boost shora nějakým způsobem omezena. Odpovědí bylo to, že stejně jako v grafu není vyznačeno žádné omezení, tak ani ve skutečnosti se žádné omezení nekoná a takty závisejí pouze na teplotě a spotřebě (byť ne lineárně). Takovým způsobem jsme technologii prezentovali i v našem článku.

Podle zjištění Damiena Trioleta ale GPU Boost funguje trošku odlišně. Jistě jste si všimli, že v rámci různých recenzí můžete narazit na odlišnosti v taktovacích frekvencích, které bývají vysvětlovány odlišnou teplotou (chlazením) a spotřebou (která se kus od kusu liší, což je důsledek variability výrobního procesu TSMC). Triolet ale zjistil, že existuje pět typů karet - jednotlivé kusy jsou certifikovány pro určitou frekvenci, která je pak maximem, na něž GPU Boost kartu přetaktovává.

Vzorek, který měl k dispozici Hardware.fr je (stejně jako vzorek, který jsme testovali na DIIT) certifikovaný na 1110 MHz. To je ovšem maximální hodnota: Reálně (v prodeji) existují karty certifikované na 1058 MHz, 1071 MHz, 1084 MHz, 1097 MHz a zmíněných 1110 MHz (jde o násobky 13 MHz).

GeForce GTX 680 - variace GPU Boost mezi kartou certifikovanou na 1084 MHz a 1110 MHz

-zdroj: Hardware.fr -

Triolet vzal vzorek od Nvidie (kvalifikovaný na 1110 MHz) a kartu z běžného prodeje (kvalifikovanou na 1084 MHz) a srovnal jejich výkon. Při měření zaznamenal rozdíl až 5,3 % v Anno 2070, což komentuje slovy:

|

„V případě GK104-400 [pozn.: aktuální verze čipu GK104] - snad proto, že je GeForce GTX 680 výkonnostně tak blízko Radeonu HD 7970 - využívá Nvidia doslova každou jednotku výkonu, kterou může … i přesto, že se takový cíl neslučuje s možnostmi výrobního procesu. Jinými slovy, Nvidia by ráda ukazovala výkon 1110MHz GPU při výtěžnosti výroby 1058MHz čipu.“

• Damien Triolet, Hardware.fr |

Je tedy třeba přehodnotit stávající pohled: Dosažené frekvence nezáleží pouze na spotřebě a teplotě konkrétní karty (ať jsou obě hodnoty ovlivněné kvalitou chlazení sestavy nebo konkrétním kusem karty), ale cílové frekvence jsou pevně nastavené podle toho, co která karta zvládá. Na teplotě a spotřebě závisí to, zda GPU přednastavené hodnoty dosáhne.

Kvalita chlazení a spotřeba daného čipu má tedy vliv na to, jak často bude dosaženo přednastavené frekvence, nikoli na to, jakou maximální frekvenci bude GPU Boost nastavovat (tu má čip určenou podle kvalifikace). Prakticky to znamená, že pokud na uživatele vyjde karta s limitem nastaveným (například) na 1058 MHz, pak kvalita chlazení ovlivní pouze četnost dosažení této meze, nikoli výši samotné meze (protože ta je nastavena fixně - v tomto případě na 1058 MHz).

Tolik k upřesnění, nyní je na řadě hodnocení. GPU Boost byl nejednou srovnáván s režimem Turbo, který taktuje procesory (Intelu i AMD) v situacích, kdy nedosáhly limitu TDP. Nyní se ukazuje, že je toto srovnání chybné, protože zákazník při nákupu procesoru ví, na jakou frekvenci se bude přetaktovávat a zároveň dostane přesně takový výkon, který viděl v recenzích. Oproti tomu GeForce GTX 680 se podle kusu může přetaktovávat na pět různých hodnot a zákazník tak kupuje příslovečného zajíce v pytli, protože neví, jaký kus dostane.

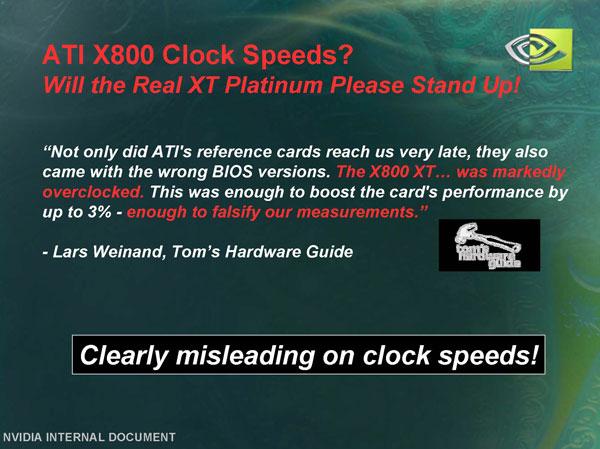

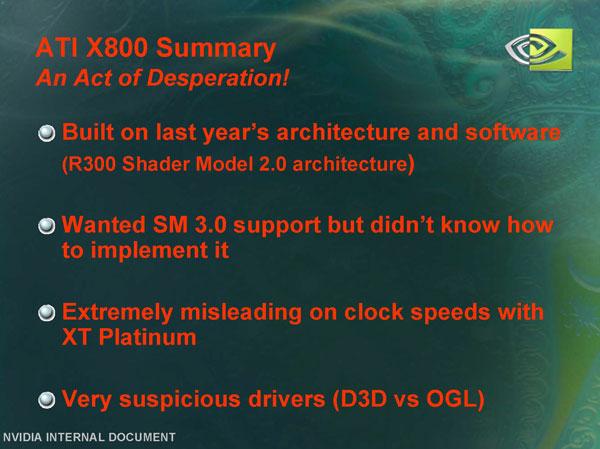

Jak tedy situaci posoudit: Toto téma je poměrně ožehavé, a tak budeme hodnotit šalamounsky - způsobem, který musí působit nanejvýš objektivně, protože jde o slova, která v podobném případě použila samotná Nvidia. Když roku 2004 ATi vydala Radeon X800 XT-PE a server Tomshardware (ať již omylem nebo záměrně) dostal vzorek, jehož paměti byly nataktované namísto referenčních 560 MHz na 575 MHz (tedy o 2,7 % výše než měly karty v obchodech), vyjádřila se Nvidia následovně…

… a tuto praktiku označila za „jasně a extrémně zavádějící“.

- Nvidia GeForce GTX 680 s čipem GK104: Herní Kepler detailně - GPU Boost

- AMD PowerTune versus Nvidia GPU Boost - druhý pohled

Aktualizace 4.5.2012 v 16:00: Obdrželi jsme předběžné stanovisko Nvidie, která s tímto článkem a jeho popisem problematiky GPU Boost nesouhlasí s tím, že jej prezentovala v San Franciscu jinak. K tématu GPU Boost se na našem serveru ještě výhledově vrátíme.