Ceny HBM3 raketově stoupají, může za to ChatGPT

ChatGPT, chatbot (kecálek) postavený na bázi umělé inteligence vyžaduje pro své fungování zpracování velkých objemů dat s využitím akcelerátorů umělé inteligence. Zprvu pro tento účel používal Nvidia A100 s jádrem Ampere GA100, ale další rozšiřování už počítá s Nvidia H100 postaveným na bázi jádra Hopper GH100.

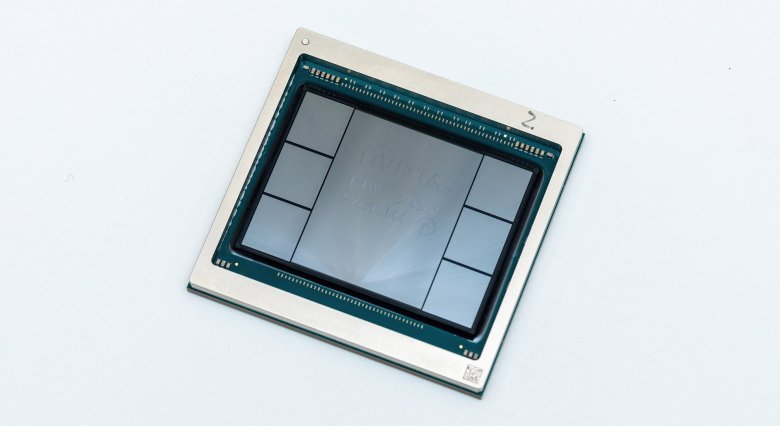

Téměř před rokem představený akcelerátor Nvidia H100 má oproti svému předchůdci jedno specifikum: Namísto pamětí HBM2E využívá HBM3. Paměti HBM se původně měly stát náhradou za GDDR, ovšem během předchozí krize ve výrobě polovodičů a zejména pamětí se je jejich výrobci (plány změnil především Samsung) rozhodli podržet cenově nahoře a udělat z nich řešení, které si cenově může dovolit prakticky jen profesionální high-end. To se povedlo, v důsledku čehož z pamětí původně používaných v desktopových i mobilních grafikách rychle stalo řešení pro výpočetní akcelerátory.

Nvidia Hopper GH100 s HBM3

Donedávna se cena nejnovějších HBM řešení pohybovala na úrovni trojnásobku ceny nejnovějších GDDR. S boomem ChatGPT a poptávkou po Hopper GH100 však cena HBM3 vyletěla na pětinásobek, opět ve srovnání s GDDR - nikoli na pětinásobek své původní ceny, jak mylně prezentují některé weby, jež nebudu jmenovat (WCCFTech).

Ze situace profitují společnosti Hynix a Samsung, které mají HBM3 v nabídce. Celkově zůstává špičkou v oboru Hynix, který původní HBM ve spolupráci s AMD vyvinul. Na trhu s těmito pamětmi si drží 60-70% zastoupení. Krom zmíněných značek oznámil před časem vstup na trh také Micron, jehož HMC (jejichž zpožděný vývoj inicioval vznik HBM standardu) skončily v propadlišti dějin a dále GlobalFoundries, jenž o výrobě HBM mluvila snad již v roce 2021 (ovšem dosud bez hmatatelného výsledku).