Pár slov na závěr

Kapitoly článků

Faktem je, že (obecně) čip s PCIe řadičem lze jen těžko napojit přímo na QPI sběrnici, že má řádově jinou spotřebu i jiný pinout, než na jaké jsou všechny současné sockety navržené a že by neměl k dispozici paměti o dostatečné kapacitě a přenosové kapacitě, jakými disponuje klasické řešení (samostatná karta s rychlou paměti a vlastními napájecími obvody).

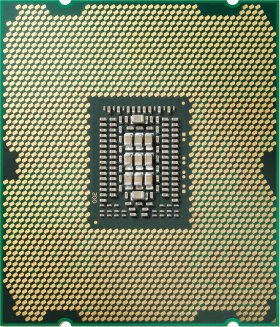

nejnovější Intel LGA 2011 by co do počtu pinů pro GPU koprocesor dostačovat mohl,

ale celková nekompatibilita (rozložení, signály, napájení) to samozřejmě vylučuje

Dalším problémem je samotná nekompatibilita socketů (odlišná napětí, signály, rozložení…). Vezměme v potaz, že výrobci procesorů musejí i kvůli odlišnému rozložení funkčních bloků (v rámci křemíku) měnit design socketu. Nelze proto očekávat, že by například úpravou balení GPU bylo možné změnit rozložení pinů takovým způsobem, aby se jen vzdáleně blížily požadavkům stávajících patic.

Pokud připustíme, že by i přesto chtěli výrobci GPU dostat do procesorového socketu, stáli by před velmi obtížným úkolem vyřešení kompatibility pinů, signálu a napájení. I kdyby toto vyřešili, GPU podtaktovali, aby mu stačily níže dimenzované napájecí obvody a drasticky omezili šířku a frekvenci paměťové sběrnice, aby jej bylo možné napojit na systémovou paměť, dostali by se do situace, kdy GPU o ceně řekněme $100 podá z důvodu jmenovaných omezení výkon rovný čipu o ceně $30.

Dr. David Kirk, Chief Scientist, nVidia

Nevidíme důvod, proč by si AMD nebo jiný výrobce měl zcela zbytečně vytvářet problémy, které ani není třeba řešit. Jak demonstruje celkem úspěšně Nvidia, není řešení postavené na PCIe kartách konstrukčně problém ani pro různé 1U servery.

Nelze se pak divit slovům AMD, podle nichž jsou optimálními GPGPU procesory pro CPU socket právě APU Fusion, jejichž grafický procesor je dimenzovaný právě tak, aby dokázal s ohledem na omezené možnosti napájení a paměťové propustnosti poskytnout maximální možný výkon.